IA y Educación. Reconocimiento facial, #AIAct, lo nuevo de OpenAI, Gemini en Workspaces, el Modelo PIO y más podcasts de IA

Este artículo pertenece a una serie donde cada semana comparto una selección curada de lecturas sobre Inteligencia Artificial y Educación. Espero que te resulte interesante. Si quieres estar al tanto de cada nueva publicación te recomiendo que o bien te suscribas al feed del blog con una herramienta como feedly, o bien te suscribas vía e-mail. Encontrarás ambas opciones en la columna lateral 👉

Tras algunas semanas de relativa tranquilidad en relación a los desarrollos y aplicaciones de la Inteligencia Artificial, el pasado viernes OpenAI vuelve a revolucionar este campo con la presentación de una nueva herramienta, que lleva por nombre SORA, que permite crear vídeos de una calidad y una duración inéditas hasta el momento simplemente usando prompts de texto. Un par de ejemplos:

El prompt para generar esta vídeo es: “Beautiful, snowy Tokyo city is bustling. The camera moves through the bustling city street, following several people enjoying the beautiful snowy weather and shopping at nearby stalls. Gorgeous sakura petals are flying through the wind along with snowflakes», cuya traducción sería «hermosa, nevada ciudad de Tokio llena de actividad. La cámara se desplaza por la concurrida calle de la ciudad, siguiendo a varias personas que disfrutan del hermoso clima nevado y compran en puestos cercanos. Hermosos pétalos de sakura vuelan con el viento junto con los copos de nieve.»

Otro ejemplo:

Prompt: “Several giant wooly mammoths approach treading through a snowy meadow, their long wooly fur lightly blows in the wind as they walk, snow covered trees and dramatic snow capped mountains in the distance, mid afternoon light with wispy clouds and a sun high in the distance creates a warm glow, the low camera view is stunning capturing the large furry mammal with beautiful photography, depth of field.”

Traducción: «Varios mamuts lanudos gigantes se acercan pisando a través de un prado nevado, su larga y lanuda piel ondea ligeramente con el viento mientras caminan, árboles cubiertos de nieve y dramáticas montañas cubiertas de nieve en la distancia, la luz de la tarde con nubes vaporosas y un sol alto en la distancia crean un cálido resplandor, la vista baja de la cámara es impresionante capturando al gran mamífero peludo con hermosa fotografía, profundidad de campo.»

Por el momento sólo tenemos acceso, además de a estos y otros muchos espectaculares ejemplos de SORA, a un informe técnico descafeinado, en la línea de anteriores artículos e informes de OpenAI, para evitar que su competencia tenga información realmente relevante sobre el desarrollo del modelo.

Esta semana también llegaba ya la nueva IA generativa de Google, que viene a sustituir a Bard, y que ya está disponible incluso para las cuentas Google Workspace: Gemini, de la cual ya te hablábamos a comienzos de diciembre. Puedes echar un vistazo al artículo, publicado en el blog de la Biblioteca de Traducción y Documentación de la Universidad de Salamanca, con una comparativa entre Gemini y ChatGPT.

También en este blog publicaban, hace exactamente un mes, un artículo en el que comentaban los resultados de una encuesta realizada a 2.778 investigadores/as sobre el futuro de la IA, que revela una clara división entre los «aceleracionistas» y los «pesimistas» de la IA, con una clara tendencia hacia una adopción más rápida de la tecnología.

Para mirar hacia el presente y el futuro de la IA merece la pena escuchar a Jaron Lanier [por cierto, coautor junto a Néstor Alonso de una de nuestras camicitas favoritas]. El canal en YouTube de Bloomberg en español ha publicado una entrevista, que además está doblada al castellano con Papercup, una herramienta que usa IA:

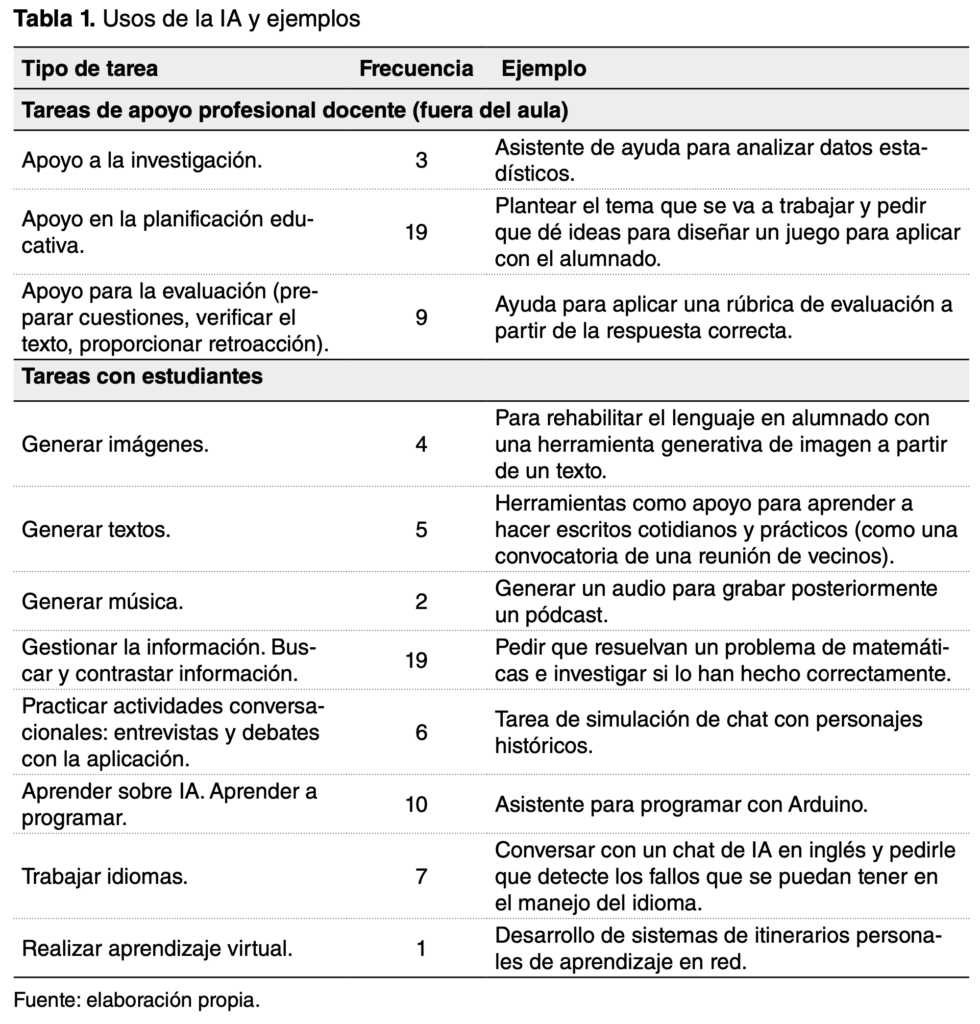

María del Mar Sánchez Vera, PDI de la Universidad de Murcia y miembro de nuestro equipo de personas expertas en IA, acaba de publicar en la Revista Educar el artículo La Inteligencia Artificial como recurso docente: usos y posibilidades para el profesorado. Este artículo recoge un estudio descriptivo de enfoque mixto con docentes, llevado a cabo durante los meses de marzo y abril de 2023, que revela que las herramientas de IA que más utiliza el profesorado [tanto en la preparación de las clases como en el aula] son las generativas y conversacionales. Y que, aunque el profesorado manifiesta su preocupación por una formación adecuada y por los problema de plagio, la IA se percibe como un instrumento que puede mejorar la enseñanza y el aprendizaje. Además, el análisis cualitativo ha permitido generar la siguiente clasificación de actividades educativas que integran IA:

Más recursos interesantes: Manuel Jiménez, asesor del CEP de Córdoba, compartía la presentación que acompañaba su charla«La IA os va a quitar el trabajo» para la #Sysmana2024 organizada por el Departamento de Informática y Comunicaciones del IES Gran Capitán de Córdoba:

Entre las aplicaciones más inquietantes de la IA está, sin duda, el reconocimiento facial. Una versión básica de esta funcionalidad ya está incorporada en la mayoría de los smartphones actuales. Podemos identificar esta funcionalidad cuando, al hacer una foto, vemos cómo en la pantalla se resaltan las caras de las personas que están posando. Aplicaciones más sofisticadas de reconocimiento facial son las que nos permiten desbloquear el smartphone o incluso autorizar una compra. La publicación El reconocimiento facial es un superpoder, de Aniceto Pérez y Madrid, nos ofrece un análisis técnico, social, ético y regulatorio de las tecnologías de IA para reconocimiento facial. Un buen documento para empezar a explorar estas cuestiones.

La tendencia a incorporar sistemas de monitorización apoyados en IA va a ser, sin duda alguna, uno de los temas que más debates va a provocar en el ámbito educativo. Esta práctica, sobre la que tenemos noticias desde hace algún tiempo, especialmente en el ámbito educativo en el caso de países como China [1, 2] o en el laboral como en Corea del Sur, ha puesto en marcha iniciativas para «frenar y regular» estas tecnologías.

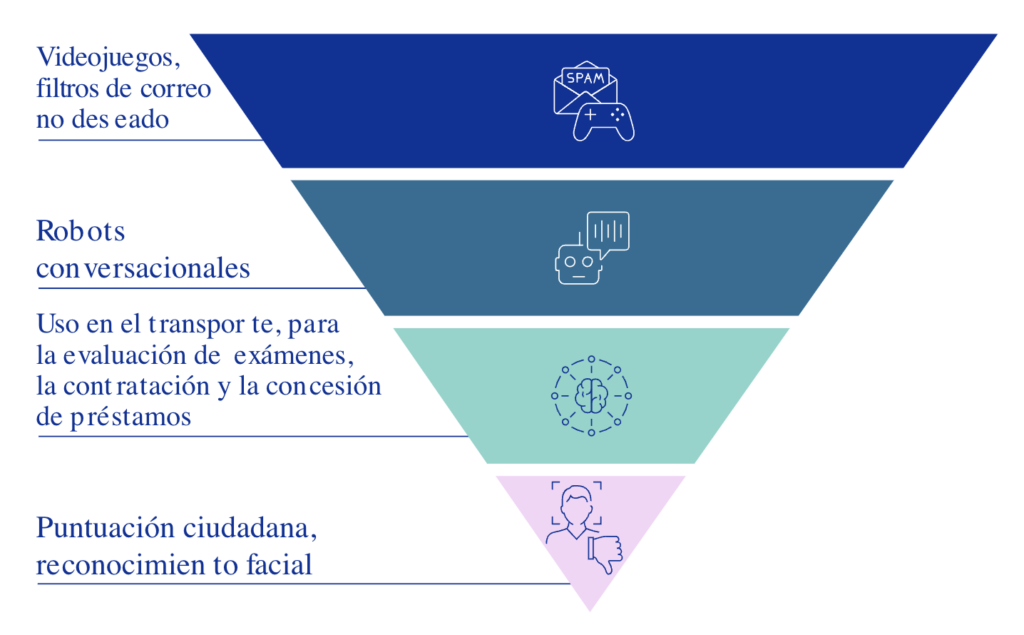

En Europa, la Ley de Inteligencia Artificial aprobada por el Consejo y el Parlamento Europeo, cataloga los sistemas de identificación biométrica remota [como el reconocimiento] entre los usos de la inteligencia artificial de riesgo inaceptable, junto con aquellos que incluyan la manipulación cognitiva conductual, la actuación policial predictiva o el reconocimiento de emociones en lugares de trabajo y centros educativos. El siguiente gráfico [cuya versión interactiva puedes encontrar en la página del Consejo] muestra los cuatro niveles en los que clasifica, según su riesgo, las aplicaciones de la inteligencia artificial:

La Dra. Naomi Fisher, una reconocida psicóloga clínica americana, publicaba hace un par de domingos un mensaje en Twitter/X en relación a esta cuestión. En el citado mensaje señala el impacto negativo de estas aplicaciones en la salud mental de los jóvenes y sus padres. Fisher se pregunta si las constantes alertas de este tipo de sistemas son beneficiosas para los jóvenes que ya están lidiando con dificultades y enfatiza la necesidad de evaluar los riesgos y tener en cuenta el impacto que puedan tener en los más vulnerables. Como sabes, USA, los países orientales y la UE tienen diferentes políticas en relación al desarrollo y uso de los sistemas de IA.

En otra dimensión, pero también ligado a los riesgos de la IA, leía esta semana en The Deepfake Porn Problem Is Bigger Than Taylor Swift sobre el uso de herramientas generativas para actos de ciberviolencia de índole sexual. Las imágenes de desnudos de la artista Taylor Swift, creadas con IA y distribuidas sin su consentimiento hace un par de semanas [un tipo de contenidos digitales conocidos como deepfakes], vuelve a centrar la atención sobre cómo este uso de la IA afecta no sólo a mujeres famosas sino también a personas anónimas, así como la necesidad de un enfoque centrado en la víctima en las legislaciones para abordar este problema. Recordemos el caso de las niñas de un colegio de Almendralejo que habían sido víctimas de este tipo de agresión. Es obvio que la escuela no puede dar la espalda a estas cuestiones y revela la importancia de trabajar con el alumnado el uso ético de las tecnologías, y muy especialmente las de IA.

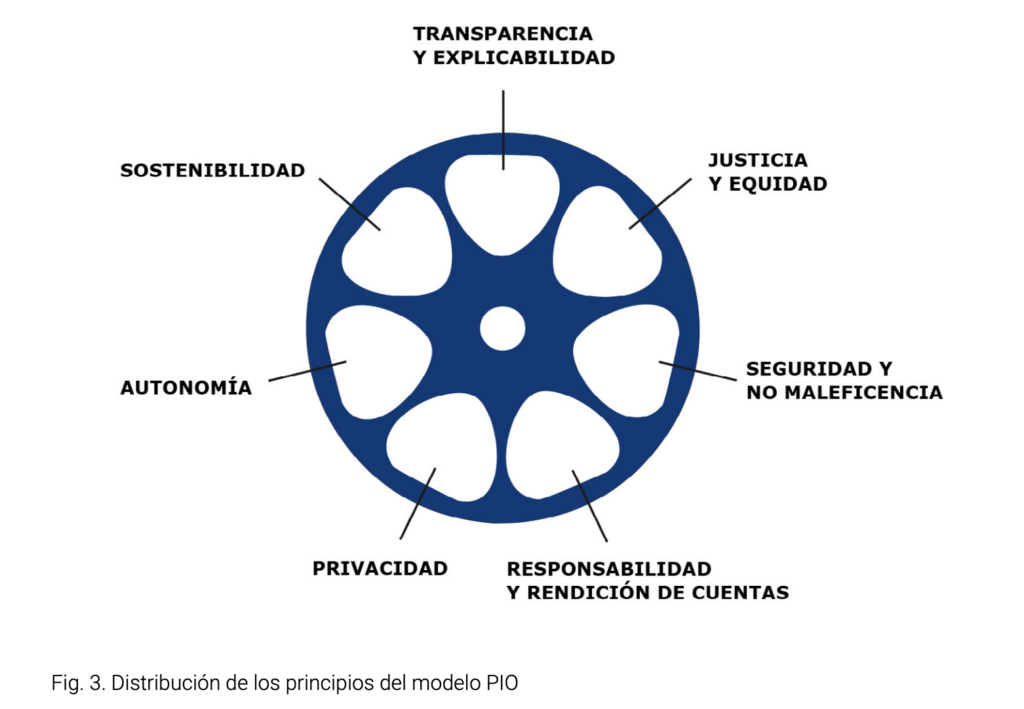

La Universidad de Girona, a través de la Cátedra Observatorio de Ética en Inteligencia Artificial, que dirige Albert Sabater, ha desarrollado un modelo de autoevaluación del uso ético de datos y sistemas de inteligencia artificial para organizaciones: el Modelo PIO. El objetivo de este modelo, cuyo nombre es el acrónimo de Principios-Indicadores-Observables, es sensibilizar a los diferentes agentes que utilizan datos y sistemas de inteligencia artificial sobre la importancia de adoptar principios éticos fundamentales para minimizar riesgos conocidos y desconocidos, así como para maximizar oportunidades. También persigue identificar acciones adecuadas o inadecuadas a través de una propuesta de autoevaluación basada en principios, indicadores y observables para poner en valor, recomendar y avanzar en el uso ético de datos y sistemas de inteligencia artificial. Además han publicado un informe, disponible en catalán, castellano e inglés, a modo de guía de implementación y autoevaluación para las organizaciones. El modelo PIO se basa en 7 principios éticos, que se muestran en el siguiente gráfico:

Los problemas éticos relacionados con los sesgos de las IAs siguen sobre la mesa. Lorena Fernández compartía un artículo que recoge una reciente polémica ocurrida en Austria: un chatbot de empleo basado en ChatGPT sugería recursos formativos y laborales relacionados con la ingeniería a los hombres, mientras que a las mujeres le recomendaba recursos relacionados con la hostelería. Como dice la propia Lorena en otro tweet «necesitamos datos inclusivos para crear una sociedad justa y equitativa: se trata de garantizar que cada persona sea vista, escuchada y contada» y nos recomienda la propuesta generada en un Festival de Datos desarrollado por Global Partnership, Data2X and Sightsavers el pasado mes de noviembre [aquí puedes consultar la grabación del evento] que lleva por título Inclusive Data: Five Key Principles for Success.

Otra de las cuestiones clave en relación al futuro de la IA es el de su impacto medioambiental. En el blog de Programamos nos dejan algunas reflexiones al respecto.

Por otra parte, Julen Iturbe se pregunta «¿qué no quiero que haga la tecnología por mí?» y nos deja, como siempre, valiosas reflexiones como la que reproduzco a continuación:

«Con la llegada de la inteligencia artificial generativa surge aún con más fuerza la pregunta: ¿hasta dónde dejo que sea ella la que haga las cosas? ¿Para qué leer un texto y resumirlo si lo puede hacer por mí? ¿Para qué dedicarle diez minutos si podría hacerlo en dos? Y entonces, surge otra pregunta: ¿qué hacemos con esos ocho minutos que «ganamos»? La falacia de la productividad lo tiene claro: hacer otras cosas… productivas. Y en esa carrera de la rata uno no sabe cuándo saltará la banca, porque la lógica dice que lo hará.»

Como hemos comentado en varios artículos anteriores, en el futuro [que ya está aquí] tendremos IA en cualquier herramienta que podamos imaginar, aumentando sus capacidades de una forma absolutamente transparente para los usuarios. Por ejemplo, ya tenemos navegadores que incorporan IA y que se postulan como serias alternativas a los navegadores más populares. Es el caso de Brave y de Arc. El primero ha integrado Mixtral 8x7B [el segundo LLM desarrollado por Mistral] en su chatbot Leo, que te permite resumir información en páginas web y responder a preguntas sobre su contenido. El segundo te permite, desde el 26 de enero, cambiar el motor de búsqueda predeterminado por Perplexity, un motor de búsqueda generativo de IA que vendrá incorporado en el asistente r1 de Rabbit, otro de los nuevos dispositivos que están emergiendo en los últimos meses.

Cerramos este artículo con varias propuestas de podcasts:

- Comenzamos con el podcast educativo EduHacking que dirige y produce José Luis Serrano, PDI de la Universidad de Murcia. Ya van publicados 61 episodios, varios de ellos relacionados con la Inteligencia Artificial:

- Los amigos del podcast IA y Educación han publicado tres episodios nuevos desde que publicamos el último post:

- Ep #53: ¿Cómo estamos aquí?, que incluye la segunda parte de la entrevista que publicaron en el episodio anterior.

- Ep #54: Impactos Sociales, con el amigo Miguel Ángel Ronda.

- Ep #55: Innovar y Aprender, con la segunda parte de la entrevista anterior.

- El Instituto Andaluz de Inteligencia Artificial publica también un fantástico podcast, SintonIA DaSCI, que dirigen con maestría y buen humor Rocío Romero y Fco. Javier Martínez, y en el que también tuve también la suerte de participar. Grabamos en una asignatura del Máster de Profesorado, cuyo alumnado participó con algunas preguntas más interesantes que mis respuestas. Te dejo el enlace al episodio y una galería de fotos cortesía de @gdarzs que vino a inmortalizar el encuentro. ¡Feliz finde!